YOLOv8 (객체 감지)¶

YOLOv8은 객체 감지 분야에서 탁월한 성능을 보이는 인공 신경망 모델로, 낮은 지연 시간과 적은 매개변수로도 뛰어난 성능을 보여줍니다. YOLOv8은 C2f와 Spatial Pyramid Pooling Fast (SPPF) 블록들을 기반으로 하여 다양한 작업을 효과적으로 수행합니다. YOLOv8에 대한 자세한 정보는 YOLOv8 공식 문서에서 찾아볼 수 있습니다.

사전 준비¶

설치¶

모델 컴파일 및 RBLN 프로파일러 활성화¶

환경변수 대신 RBLN 런타임 API를 사용할 때에는 런타임 모듈 생성에서 activate_profiler=True를 설정하는 것으로 RBLN 프로파일러를 활성화할 수 있습니다:

추론을 통한 프로파일링 데이터 추출¶

모델 추론을 통해 프로파일링 데이터를 얻을 수 있습니다:

또는 구역이 지정된 프로파일링 메서드를 사용하여 프로파일링 데이터를 얻을 수 있습니다:RBLN 프로파일러 기반 YOLOv8l의 프로파일링 데이터 분석¶

프로파일링 결과¶

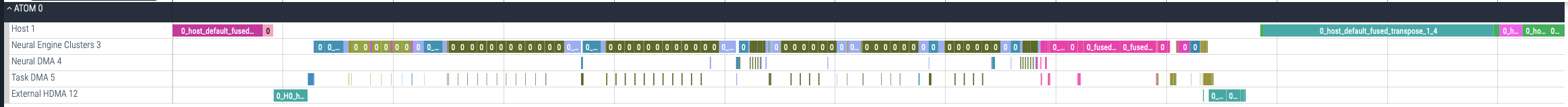

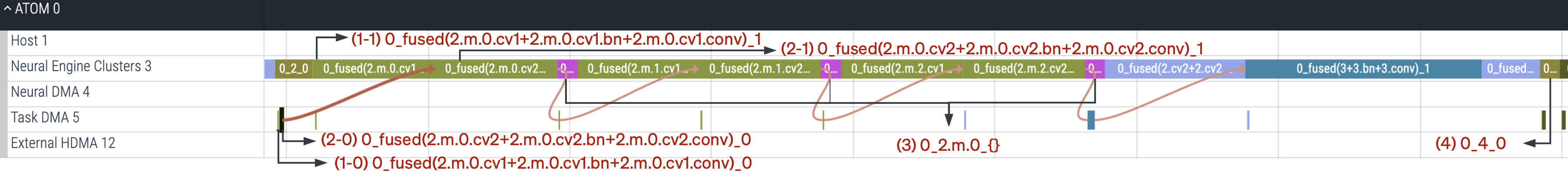

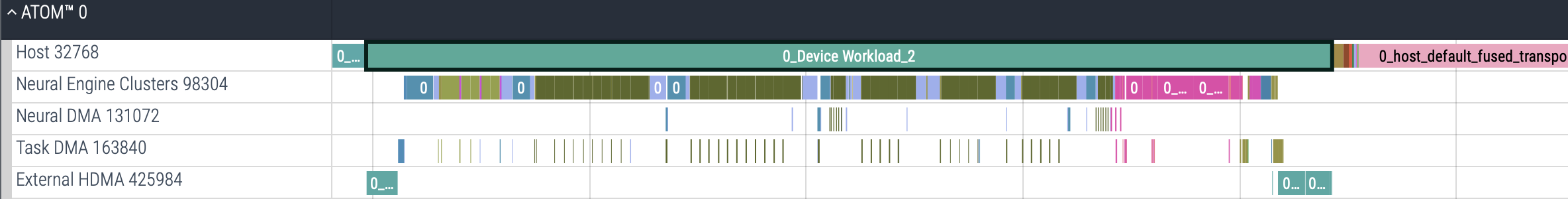

위 그림에서 확인할 수 있는 것처럼, YOLOv8l 모델은 ATOM™을 통해 효율적으로 가속되고 있습니다. 이제 위 그림의 연산들을 하나씩 분석해 보겠습니다.

Host 명령어¶

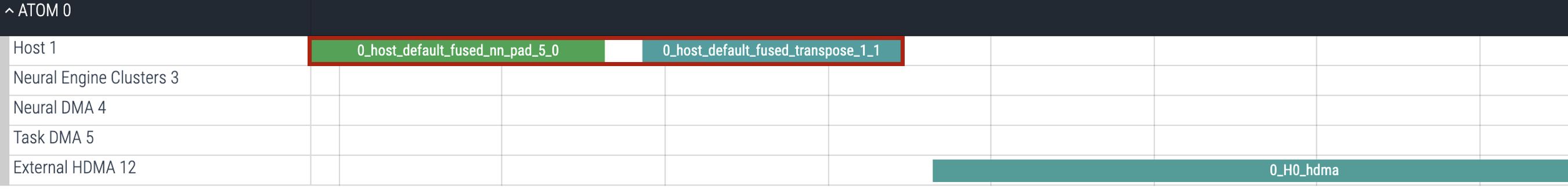

위 그림에서의 Host 명령어(0_host_default_fused_nn_pad_5_0, 0_host_default_fused_transpose_1_1)는 External HDMA 명령어를 통해 입력을 ATOM™로 전달하기 전, 입력의 형태를 ATOM™에 맞게 적절하게 변형해주는 역할을 합니다. 마찬가지로 Yolov8l 모델의 실행 결과는 External HDMA을 통해 호스트 CPU로 전달된 후, 적절한 Host 명령어를 통해 사용자가 원하는 형태의 출력으로 변형되고 있습니다. Host 명령어의 이름은 기본적으로 내부 로직에 의해 결정되고 이름 앞에 host를 포함하고 있습니다.

입력 흐름¶

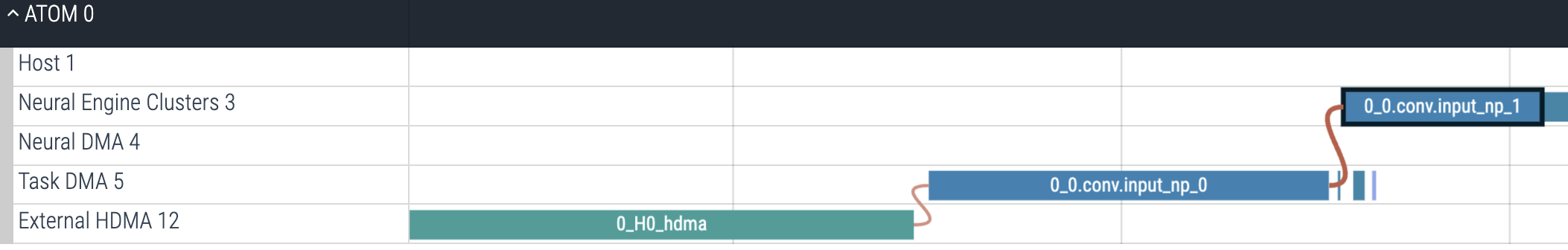

위 예시에 나타난 것처럼, YOLOv8l의 첫 번째 Neural Engine Clusters 명령어는 0_0.conv.input_np_1입니다. 이 명령어는 바로 앞의 Task DMA 명령어(0_0.conv.input_np_0)와 연결되어 있습니다. 이것은 두 명령어 사이의 의존성을 나타냅니다. 또한, 이 두 명령어는 command index를 제외하고 동일한 이름을 공유하고 있다는 점에서도 두 명령어 사이의 의존성을 유추할 수 있습니다. 이 명령어들의 이름은 컴파일 과정에서 모델의 첫 번째 연산인 conv와 입력 데이터의 이름 input_np의 조합입니다.

External HDMA 명령어(0_H0_hdma)를 통해 호스트에서 ATOM™ 내부의 메모리로 전송됩니다. 뒤이어, 이 데이터는 Task DMA 명령어(0_0.conv.input_np_0)를 통해 Shared Memory로 옮겨지고, Neural Engine Clusters 명령어(0_0.conv.input_np_1)에서 사용됩니다.

이와 비슷하게 출력 데이터는 입력 데이터 전송의 반대 방향으로 전송됩니다. Task DMA와 External HDMA 명령어를 통해 출력 데이터가 각각 Shared Memory와 DRAM을 거쳐 호스트의 DRAM으로 보내집니다.

C2f 블록 분석¶

모호한 명령어 이름¶

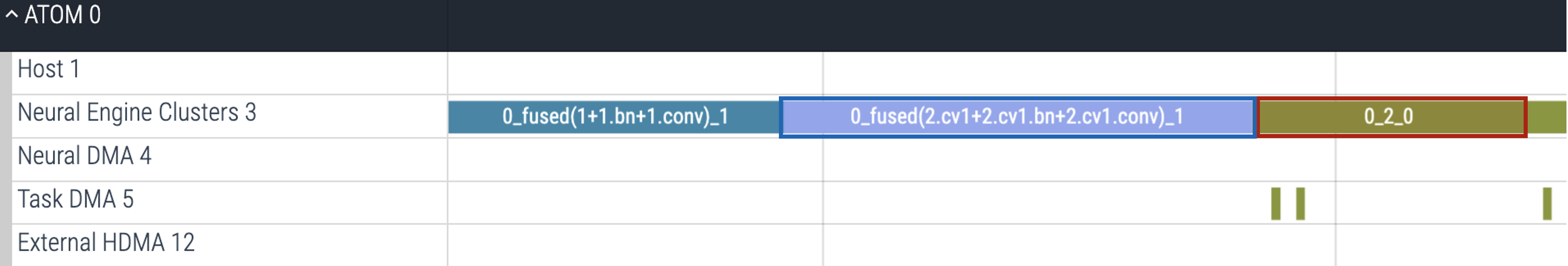

파란 박스의 0_fused(2.cv1+2.cv1.bn+2.cv1.conv)_1 명령어는 파이토치 코드 상에서 self.cv1(x)과 print(model)의 (cv1): ... 부분에 해당합니다. 따라서, 이어지는 0_2_0 명령어(빨간 박스)는 파이토치 코드 상에서 .split((self.c, self.c), 1)에 해당한다는 것을 추론할 수 있습니다. 각 명령어들의 이름을 결정하는 규칙에 대한 자세한 정보는 상세 명명 규칙 문서를 참고하시길 바랍니다.

연결 흐름¶

0_2_0 뒤에 오는 (1-1, 2-1)과 같은 명령어들은 파이토치 코드의 self.m에서 정의된 Bottleneck 계층 내부의 합성곱 블록에 해당합니다. Task DMA 명령어 (1-0, 2-0)과 Neural Engine Clusters 명령어 (1-1, 2-1) 사이의 연결은 실제 텐서 연산을 구현할 때 Neural Engine Clusters 명령어에서 가중치를 미리 불러올 필요가 있음을 보여줍니다. 명령어 (3)은 Bottleneck 블록 안의 덧셈 연산에 해당하고, 명령어 (4)는 파이토치 코드의 텐서 이어붙이기 연산(self.cv2(torch.cat(y, 1)))에 해당합니다.

Device Workload¶

위에서 알아본 것과 같이, ATOM™ 내부에서는 다수의 명령어들을 처리합니다. 사용중인 ATOM™은 Host 명령어의 Device Workload로 표시되며, 이를 통해 ATOM™ 내부에서 이루어지는 작업의 시작과 끝을 명확하게 알 수 있습니다.

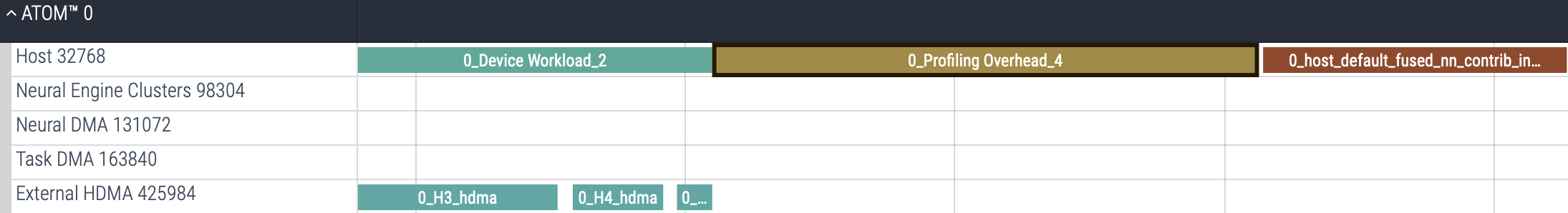

Profiling Overhead¶

RBLN profiler을 이용하여 모델을 프로파일링하는 경우, Device Workload가 종료된 후 ATOM™ 으로부터 받은 프로파일링 데이터를 정제하는 과정이 필요합니다. 이 작업에는 일정 시간이 소요되며, 이 구간은 Host 명령어에서 Profiling Overhead로 표시됩니다. 이 프로파일링 데이터를 정제하는 작업이 끝나고 나면, Host에서 남아있는 일부 명령어들을 마저 처리할 수 있습니다.